这篇笔记,仅仅是对选择性算法介绍一下原理性知识,不对公式进行推倒.

前言:

这篇论文介绍的是,如果快速的找到的可能是物体目标的区域,不像使用传统的滑动窗口来暴力进行区域识别.这里是使用算法从多个维度对找到图片中,可能的区域目标,减少目标碎片,提升物体检测效率. 下面是这篇文章的笔记:

介绍及引言:

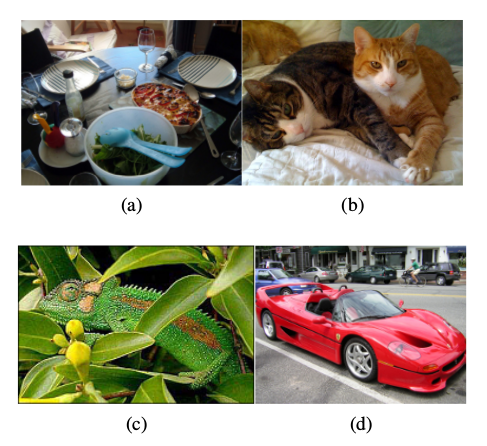

图片是分层次的,比如下图中a:

沙拉和匙在沙拉碗里,而碗又在桌子上,另外桌子和木头有关或者说桌子和桌子上的所有东西有关.所以图片中的目标是有层次的. 图片分割应该按层次来,也不存在使用单个策略这样通用的方法来进行图片分割,所以对图片分割都是基于多个策略,但是这样又会在合并区域的时候产生冲突. 比如说上图中的b图,猫可以使用颜色进行分割,但是它们的纹理是一样的. 相反的 ; 图C中的变色龙和周围的叶子在颜色上是相似的,但是在纹理上确实不同的.最后,图d中,汽车轮子和汽车在颜色和纹理上都是不同的,但是和汽车的形状吻合度很高. 对于这三个图,采用他们其中的一种视觉特征是无法来对它们进行图片分割的.

在这篇文章中,作者结合直觉分割算法和穷举搜索算法来提出这个selective search(选择性搜索)算法,使用直觉分割算法是希望达到结合图片的结构层次从下至上来分割,来产生目标区域. 使用穷举搜索算法的目的是得到所有可能是目标的区域. 选择性搜索算法,使用的是多样化在抽样算法

延伸阅读

- ssh框架 2016-09-30

- 阿里移动安全 [无线安全]玩转无线电——不安全的蓝牙锁 2017-07-26

- 消息队列NetMQ 原理分析4-Socket、Session、Option和Pipe 2024-03-26

- Selective Search for Object Recognition 论文笔记【图片目标分割】 2017-07-26

- 词向量-LRWE模型-更好地识别反义词同义词 2017-07-26

- 从栈不平衡问题 理解 calling convention 2017-07-26

- php imagemagick 处理 图片剪切、压缩、合并、插入文本、背景色透明 2017-07-26

- Swift实现JSON转Model - HandyJSON使用讲解 2017-07-26

- 阿里移动安全 Android端恶意锁屏勒索应用分析 2017-07-26

- 集合结合数据结构来看看(二) 2017-07-26

学习是年轻人改变自己的最好方式

学习是年轻人改变自己的最好方式